-

序言

-

云原生(Cloud Native)的定义

-

云原生的设计哲学

-

Play with Kubernetes

-

快速部署一个云原生本地实验环境

-

使用Rancher在阿里云上部署Kubenretes集群

-

Kubernetes与云原生应用概览

-

云原生应用之路——从Kubernetes到Cloud Native

- 云原生编程语言

-

云原生的未来

- Kubernetes架构

- Kubernetes中的网络

-

资源对象与基本概念解析

- Pod状态与生命周期管理

- 集群资源管理

- 控制器

- 服务发现

- 身份与权限控制

- 存储

- 集群扩展

- 资源调度

-

用户指南

- 资源对象配置

- 命令使用

- 集群安全性管理

- 访问Kubernetes集群

- 在Kubernetes中开发部署应用

-

最佳实践概览

- 在CentOS上部署Kubernetes集群

- 生产级的Kubernetes简化管理工具kubeadm

- 服务发现与负载均衡

- 运维管理

- 存储管理

- 集群与应用监控

- 分布式跟踪

- 服务编排管理

- 持续集成与发布

- 更新与升级

-

领域应用概览

- 微服务架构

- Service Mesh 服务网格

- 大数据

- Serverless架构

-

边缘计算

-

人工智能

-

开发指南概览

-

SIG和工作组

- 开发环境搭建

-

单元测试和集成测试

-

client-go示例

- Operator

-

kubebuilder

-

高级开发指南

-

社区贡献

-

Minikube

-

CNCF - 云原生计算基金会简介

-

CNCF章程

-

CNCF特别兴趣小组(SIG)说明

-

开源项目加入CNCF Sandbox的要求

-

CNCF中的项目治理

-

CNCF Ambassador

-

附录说明

-

Kubernetes中的应用故障排查

-

Kubernetes相关资讯和情报链接

-

Docker最佳实践

-

使用技巧

-

问题记录

- Kubernetes版本更新日志

- Kubernetes及云原生年度总结及展望

- CNCF年度报告解读

-

Kubernetes认证服务提供商(KCSP)说明

-

认证Kubernetes管理员(CKA)说明

分布式负载测试

该教程描述如何在Kubernetes中进行分布式负载均衡测试,包括一个web应用、docker镜像和Kubernetes controllers/services。关于分布式负载测试的更多资料请查看Distributed Load Testing Using Kubernetes 。

准备

不需要GCE及其他组件,你只需要有一个kubernetes集群即可。

如果你还没有kubernetes集群,可以参考kubernetes-handbook部署一个。

部署Web应用

本文中使用的镜像、kubernetes应用的yaml配置来自我的另一个项目,请参考:https://github.com/rootsongjc/distributed-load-testing-using-kubernetes

sample-webapp 目录下包含一个简单的web测试应用。我们将其构建为docker镜像,在kubernetes中运行。

在kubernetes上部署sample-webapp。

$ git clone https://github.com/rootsongjc/distributed-load-testing-using-kubernetes.git

$ cd kubernetes-config

$ kubectl create -f sample-webapp-controller.yaml

$ kubectl create -f sample-webapp-service.yaml

copy

copy部署Locust的Controller和Service

locust-master和locust-work使用同样的docker镜像,修改cotnroller中spec.template.spec.containers.env字段中的value为你sample-webapp service的名字。

- name: TARGET_HOST

value: http://sample-webapp:8000

copy

copy创建Controller Docker镜像(可选)

locust-master和locust-work controller使用的都是locust-tasks docker镜像。你可以直接下载gcr.io/cloud-solutions-images/locust-tasks,也可以自己编译。自己编译大概要花几分钟时间,镜像大小为820M。

$ docker build -t jimmysong/locust-tasks:latest . $ docker push jimmysong/locust-tasks:latestcopy

每个controller的yaml的spec.template.spec.containers.image 字段指定的是我的镜像:

image: jimmysong/locust-tasks:latestcopy

部署locust-master

$ kubectl create -f locust-master-controller.yaml $ kubectl create -f locust-master-service.yamlcopy

部署locust-worker

Now deploy locust-worker-controller:

$ kubectl create -f locust-worker-controller.yamlcopy

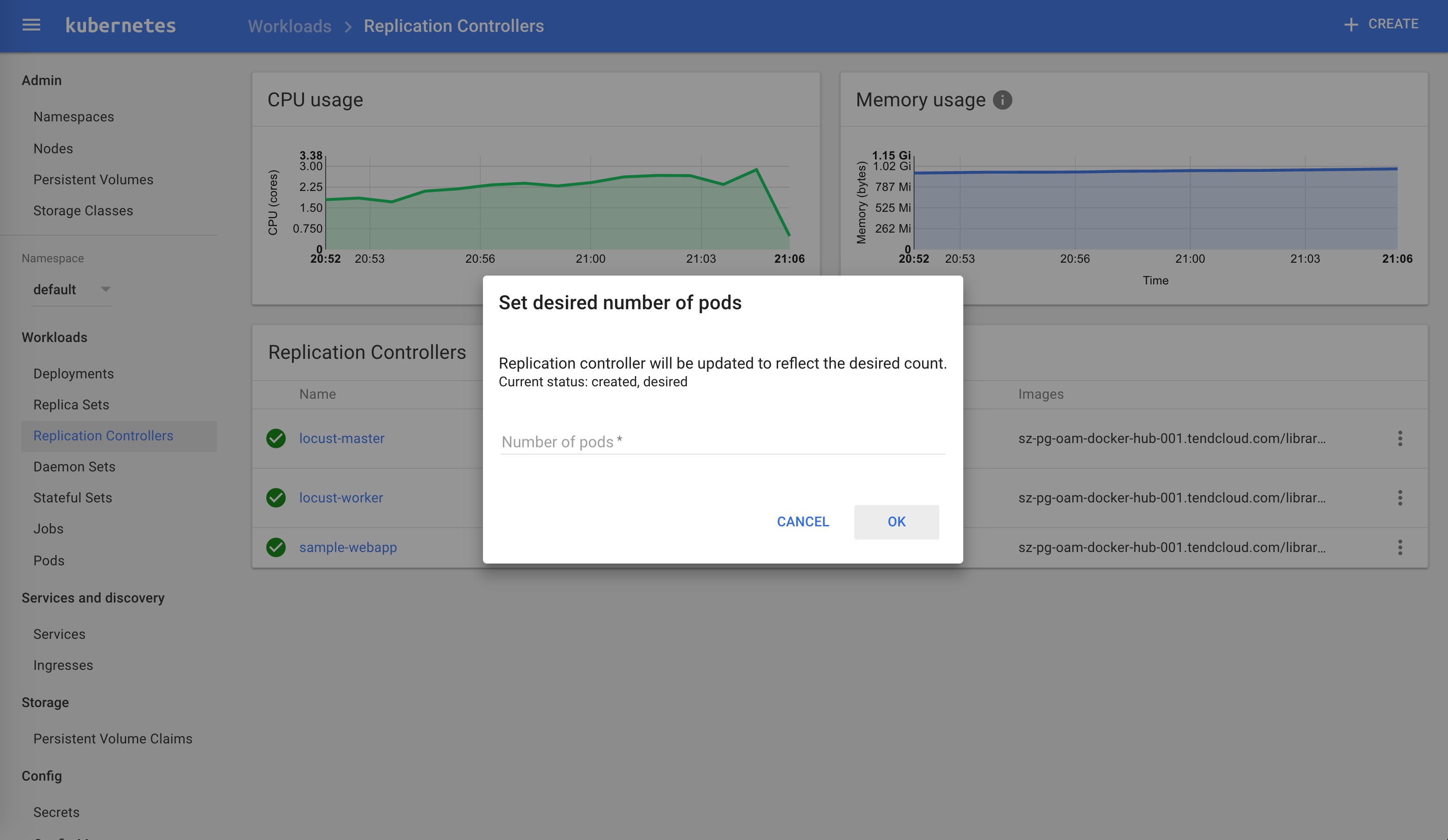

你可以很轻易的给work扩容,通过命令行方式:

$ kubectl scale --replicas=20 replicationcontrollers locust-workercopy

当然你也可以通过WebUI:Dashboard - Workloads - Replication Controllers - ServiceName - Scale来扩容。

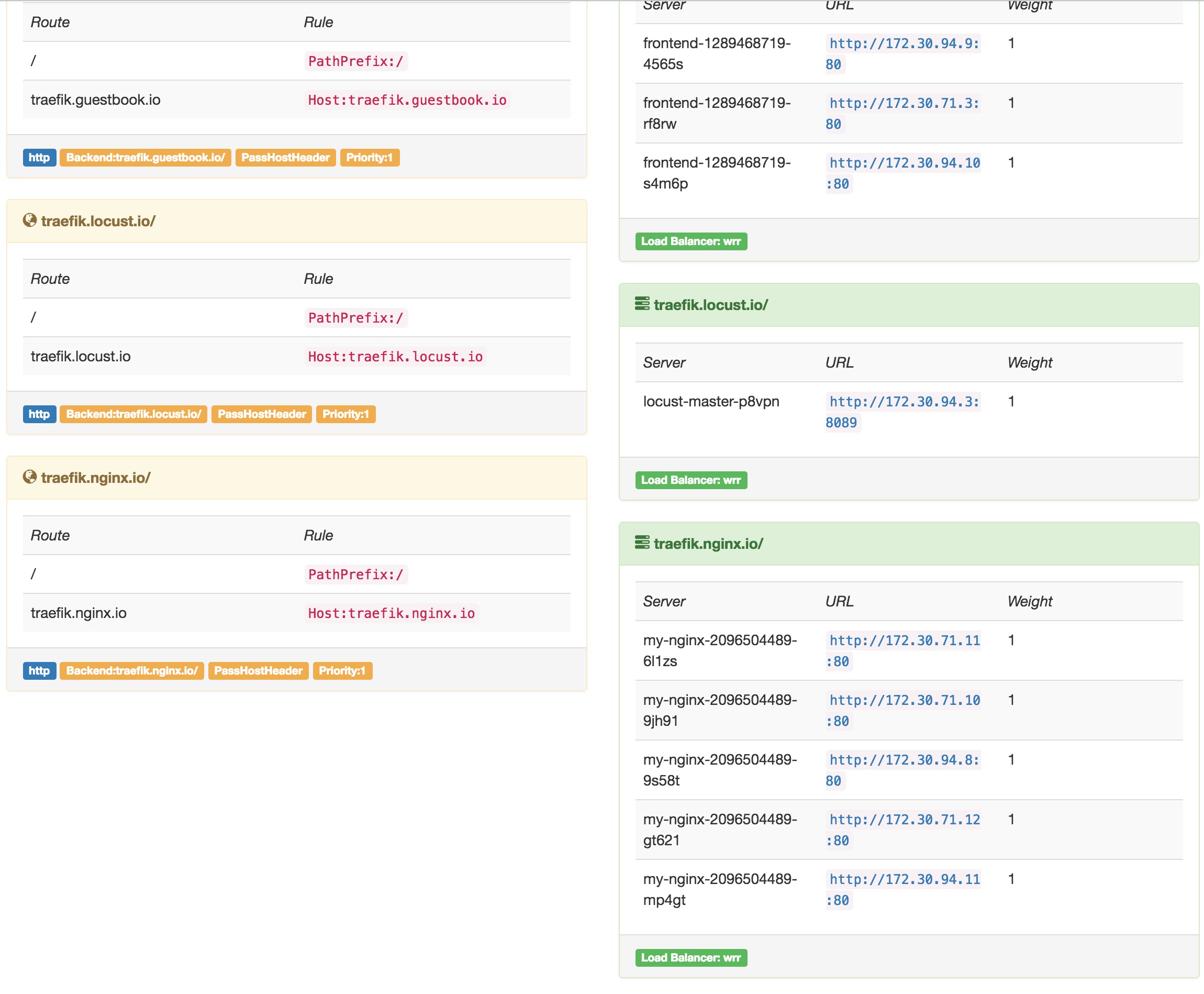

配置Traefik

参考kubernetes的traefik ingress安装,在ingress.yaml中加入如下配置:

- host: traefik.locust.io

http:

paths:

- path: /

backend:

serviceName: locust-master

servicePort: 8089

copy

copy然后执行kubectl replace -f ingress.yaml即可更新traefik。

通过Traefik的dashboard就可以看到刚增加的traefik.locust.io节点。

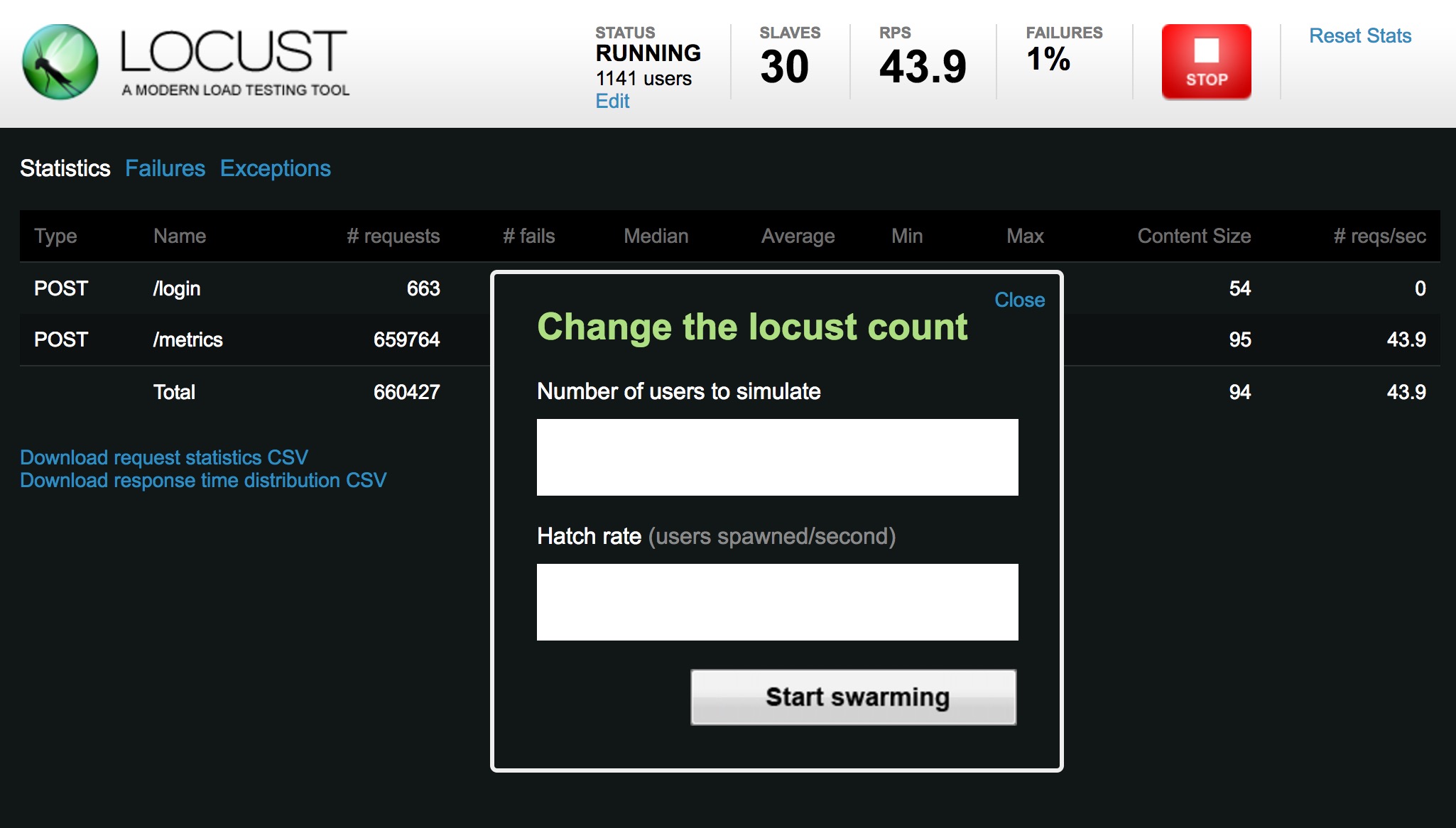

执行测试

打开http://traefik.locust.io页面,点击Edit输入伪造的用户数和用户每秒发送的请求个数,点击Start Swarming就可以开始测试了。

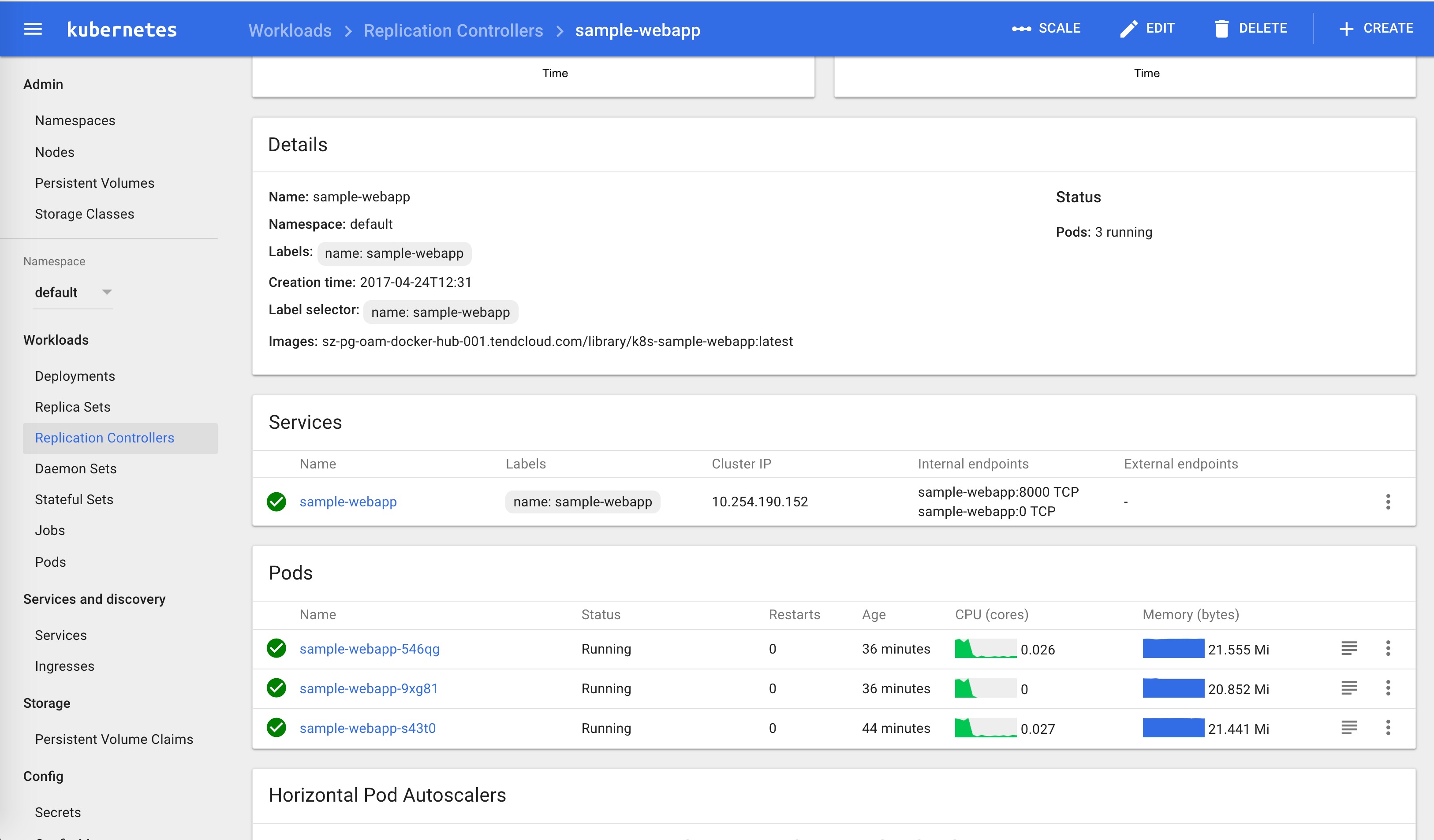

在测试过程中调整sample-webapp的pod个数(默认设置了1个pod),观察pod的负载变化情况。

从一段时间的观察中可以看到负载被平均分配给了3个pod。

在locust的页面中可以实时观察也可以下载测试结果。